El sesgo maquínico [machine-bias] es la transmisión de determinados prejuicios sociales (de clase, raza, género, etc.) a una máquina. Esto se puede dar de modo pre-meditado o como resultado de un proceso involuntario. La reflexión en torno al sesgo maquínico debe ser inscrita en la discusión más general sobre la dimensión política de la técnica: ¿son los aparatos técnicos meros medios neutrales y apolíticos, siendo solo su uso –y el sistema político y social en el que se enmarca dicho uso–, lo que determina su dimensión política?; o, por el contrario, ¿es posible sostener que determinados aparatos técnicos poseen características políticas que son intrínsecas a su constitución y a su modo de existencia?

En 1980 Langdon Winner se ocupó de estas preguntas en el breve ensayo “Do Artifacts Have Politics?”[1]. Su objetivo era refutar la ideología de la neutralidad política de la técnica. Este último enfoque, reconoce Winner, surgió como antídoto a un “determinismo tecnológico ingenuo” que comprendía los cambios históricos y sociales como efecto del desarrollo de una lógica interna de la técnica. Sin embargo, la neutralidad de la técnica terminó por imponerse como una ideología en sí misma según la cual la técnica en tanto tal era completamente ajena a las consideraciones políticas, históricas y sociales. El proyecto de Winner consiste en mostrar los modos en que los artefactos políticos pueden poseer características políticas. Uno de los ejemplos más célebres mencionados por Winner son los “puentes racistas” de Long Island diseñados por el urbanista Robert Moses. Al fijar la altura de los puentes que llevaban a los parques y las playas de esta parte de la ciudad, Moses aseguró que solo los automóviles pudiesen circular por ellos. Esta solución técnica tendría como efecto social que los usuarios del transporte público quedaran excluidos de esta zona, estableciendo una separación de clase y de raza que reproducía los prejuicios clasistas y racistas del propio Moses[2]. Los puentes de Moses son un ejemplo evidente de sesgo maquínico en el cual el prejuicio social es transmitido al aparato de modo intencional.

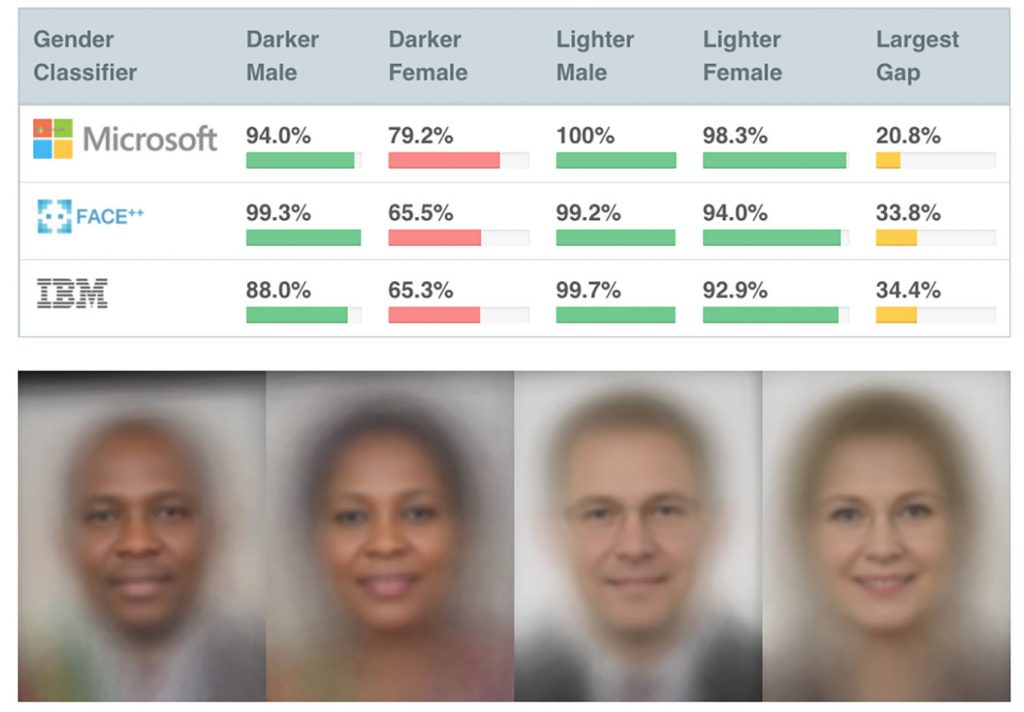

Pero hay casos en los que esta transmisión no se da necesariamente como resultado de una decisión consciente. Es el caso de los algoritmos de aprendizaje automático [machine learning algorithms]. En esta tecnología, pareciese que la transmisión de los prejuicios sociales a la máquina es estructural ya que su propio proceso de entrenamiento depende de las bases de datos que contienen en sí dichos sesgos. Se habla en estos casos de sesgo algorítmico [algorithmic bias], una forma particular de sesgo maquínico que está teniendo una incidencia cada vez mayor debido a la presencia creciente de estas tecnologías en el mundo contemporáneo y a la cantidad de decisiones que están siendo delegadas a ellas. Es importante aquí distinguir entre tres tipos de sesgo algorítmico: aquellos que dependen del programador, aquellos que dependen de la construcción de las bases de datos, y aquellos que dependen de factores históricos y sociales[3]. Ahora bien, dado que los algoritmos de aprendizaje automático dependen directamente de las bases de datos utilizadas en el proceso de entrenamiento, un grupo importante de investigaciones está poniendo énfasis en cómo estos tres tipos de sesgo cristalizan determinadas estructuras sociales presentes en las bases de datos y luego reproducen dichas estructuras a través de una aplicación supuestamente imparcial. Algunos ejemplos de estas investigaciones que denuncian el sesgo detrás de la supuesta imparcialidad y neutralidad de esta tecnología son: 1) el trabajo desarrollado por Joy Buolamwini y Timnit Gebru en el cual demuestran las asimetrías de género y raciales presentes en los principales sistemas de reconocimiento facial algorítmico y cómo estas asimetrías generan importantes diferencias de efectividad dependiendo del color de piel y del género del sujeto en cuestión[4]; 2) el libro de Caroline Criado Pérez sobre las consecuencias sociales del sesgo de género en las tecnologías de big data y machine learning[5]; 3) la investigación de Safiya Umoja Noble que examina los sesgos de los motores de búsqueda, principalmente de Google, respecto de las mujeres negras, constituyendo lo que ella denomina como “algoritmos de opresión”[6]; 4) la crítica de Chinmayi Arun respecto de cómo las tecnologías IA refuerzan la exclusión geopolítica entre el norte y el sur global[7]; 5) el reciente análisis desarrollado por Kate Crawford y Trevor Paglen que examina cómo el banco de imágenes ImageNet sobredetermina ideológicamente a los algoritmos de reconocimiento de imágenes entrenados con él[8]; 6) el trabajo de un grupo de investigadores de ProPublica que examina el sesgo racial de los algoritmos de predicción de crimen que están siendo utilizados por distintas agencias gubernamentales en Estados Unidos[9]; 7) por último, el libro de Cathy O’Neil “Armas de destrucción matemática” [Weapons of Math Destruction] el cual demuestra cómo la supuesta neutralidad estadística de las ciencias de datos [data science] reproducen asimetrías de clase, género y raza, automatizando de este modo la desigualdad social[10].

En todos estos casos mencionados, los autores quieren demostrar cómo los algoritmos de aprendizaje automático naturalizan un determinado orden del mundo presente en las bases de datos y luego presenta dicho orden como el resultado de un juicio objetivo. Ante esto, hay quienes apelan por una mejor construcción de las bases de datos para así entrenar algoritmos menos sesgados. Esta postura asume que un uso de bases de datos más representativas generaría algoritmos más “objetivos”. Joy Buolamwini y Timnit Gebru, por ejemplo, insistirán en la necesidad de un sistema de monitoreo capaz de medir la correcta distribución demográfica y fenotípica de las bases de datos. De igual modo, Tal Zarsky sostiene que el sesgo no es una característica intrínseca de las tecnologías algorítmicas, sino solamente el resultado de un set de entrenamiento deficiente[11]. Esto implica que los casos de sesgo algorítmico podrían ser resueltos a través de una mejora en las bases de datos. Si el proceso de extracción de datos y de entrenamiento de algoritmos de aprendizaje automático fuesen lo suficientemente transparentes, el sesgo algorítmico puede ser resuelto técnicamente[12]. Más aún, Zarsky sostendrá que un algoritmo bien entrenado será más rápido, más eficiente y menos sesgado que cualquier agente e institución humana. De este modo, esta tecnología debería ser considerada imprescindible para cualquier proyecto político que busque una sociedad “más justa”[13].

Habría, sin embargo, una postura alternativa a la recién mencionada. Se trata de una postura que busca no mejorar las bases de datos para alcanzar un juicio objetivo, sino de poner en entredicho (tanto técnica como conceptualmente) la posibilidad misma de un algoritmo de aprendizaje automático no sesgado. Este poner en entredicho tendría al menos tres justificaciones. En primer lugar, muchos autores han referido al proceso de “cajanegrización” que define a esta tecnología. Sabemos qué pueden hacer los algoritmos, podemos medir la eficacia con que lo hacen, pero no podemos comprender cómo lo hacen. Esto se debe no solo a una falta de transparencia de los programadores o de las corporaciones, sino principalmente a la complejidad del proceso de entrenamiento que en muchos casos vuelve irrepresentable la serie de pasos que sigue el algoritmo para llegar a una determinada decisión. Este problema de la “caja negra” se vuelve de extrema relevancia cuando se delegan decisiones éticas o políticas a estos algoritmos, exigiendo reevaluar la posibilidad de esta tecnología para producir juicios objetivos. En segundo lugar, es posible sostener que dado que hay una dependencia estructural entre estos algoritmos y las bases de datos utilizadas para su entrenamiento, el juicio objetivo es intrínsecamente imposible. Al depender directamente de las bases de datos, las formas pasadas (prejuicio) afectarán siempre las predicciones futuras. Los patrones ya existentes de asimetría de raza, de género y de clase serán con ello repetidos e intensificados por estos algoritmos a través de un proceso de retroalimentación positiva. Desde esta perspectiva, el sesgo algorítmico es un rasgo constitutivo de esta tecnología. En tercer lugar, la objetividad puede ser comprendida en sí como una operación ideológica. Al sostener que el problema del sesgo maquínico puede ser resuelto a través de mejores bases de datos se está presuponiendo la posibilidad, aunque sea hipotética, de un algoritmo neutral e imparcial, indiferente a las estructuras sociales existentes. Ahora bien, este es precisamente el triunfo de una ideología: presentarse como verdad objetiva y no como resultado de una mediación histórica y social. Una ideología opera de manera exitosa cuando aparece como orden natural. Los sistemas de aprendizaje automático se presentan como una tecnología autónoma y neutral capaz de emitir juicios objetivos precisamente con el objetivo de naturalizar un determinado orden de cosas. La ideología triunfa cuando un determinado sesgo (cultural, maquínico, algorítmico, etc.) se presenta como juicio objetivo.

Ahora bien, la noción misma de juicio objetivo ha sido un territorio de disputa desde mucho antes de la aparición del sesgo algorítmico. Según Richard Rorty, existen dos modos diferentes de definir la objetividad: objetividad como correspondencia y objetividad como acuerdo[14]. El primero puede ser definido como “realismo” mientras que el segundo como “solidaridad”. En el caso de la objetividad como correspondencia, un enunciado será objetivo si se encuentra en adecuación con la “realidad”. Esto implica entonces que para emitir un juicio objetivo la persona debe suspender toda idea preconcebida, todo sesgo transmitido por la comunidad, y acceder así a la realidad “en tanto tal”. De allí que Rorty considere esta primera noción de objetividad como “realismo”. En el caso de la objetividad como solidaridad, un juicio objetivo no es comprendido como el resultado de una relación directa y no mediada con lo real, sino como el resultado de un acuerdo entre los miembros de una comunidad. Según Rorty, las ciencias sociales han adoptado principalmente el enfoque realista, definiendo la objetividad a partir de una mirada que busca situarse por fuera de las creencias y los sesgos de una determinada comunidad. Incluso el “estructuralismo”, que busca identificar los patrones que subyacen a las manifestaciones sociales y culturales, responde al anhelo realista por encontrar la fuente de la objetividad como correspondencia[15].

Los algoritmos de aprendizaje automático poseen una capacidad sin precedente para identificar patrones, aún allí donde el ojo humano es incapaz de hacerlo. De allí que esta tecnología se esté convirtiendo en el nuevo instrumento predilecto para la búsqueda de la objetividad como correspondencia, es decir, como herramienta capaz de ofrecer un acceso no mediado a lo real. Los entusiastas nos aseguran que gracias a esta tecnología las teorías sociales (cuya función es explicar una ley general a partir de un análisis de los casos particulares) ya no serán necesarias. Así lo declaró Chris Anderson, editor de la revista Wired en 2008, para quien los algoritmos de aprendizaje automático nos darían finalmente una imagen total, y en tiempo real, del mundo, transformando a toda teoría social en una herramienta obsoleta para comprender y predecir el mundo. Se trataría del antiguo sueño de los “realistas” de tener una imagen no mediada de la realidad, libre de todo prejuicio social, dogmas, teorías, y opiniones – en una palabra, libre de todo sesgo humano. El problema es que, como hemos dicho, las tecnologías de aprendizaje automático dependen directamente del proceso de entrenamiento. Esto significa que los prejuicios y sesgos sociales son transmitidos al algoritmo a través de los bancos de datos. En los términos propuestos por Rorty, podríamos decir que los algoritmos de aprendizaje automático toman una forma de objetividad, la objetividad como acuerdo, y la “reifican”, presentándola ya no como acuerdo sino como correspondencia no mediada con lo real. Desde una perspectiva crítica, por lo tanto, habría que enfatizar que en el caso de los algoritmos de aprendizaje automático, la suspensión del sesgo que caracteriza la definición realista de la objetividad es estructuralmente imposible ya que el sistema mismo requiere de los prejuicios heredados para su entrenamiento. En conclusión, un algoritmo de aprendizaje automático no sesgado, capaz de realizar juicios neutrales y objetivos que suspendan las creencias heredadas, es técnica y conceptualmente inconcebible. Su defensa sólo puede contribuir a una reproducción ideológica de determinado orden de cosas.

Referencias

- Winner, L. (1980). Do Artifacts Have Politics? Daedalus, 109(1), 121-136. ↑

- Winner, L. (1980). Do Artifacts Have Politics? Daedalus, 109(1), 121-136. ↑

- Joler, V. & Pasquinelli, T. (2020) The Nooscope Manifested: AI as Instrument of Knowledge Extractivism. ↑

- Buolamwini, J., & Gebru, T. (2018). Gender Shades: Intersectional Accuracy Disparities in Commercial Gender Classification. ↑

- Criado Pérez, C. (2019). Invisible Women: Data Bias in a World Designed for Men. New York: Abrams Press. ↑

- Umoja Noble, S. (2018). Algorithms of Oppression: How Search Engines Reinforce Racism. New York: New York University Press. ↑

- Arun, C. (2019). AI and the Global South: Designing for Other Worlds. The Oxford Handbook of Ethics of AI. London: Oxford University Press. ↑

- Crawford, K., & Paglen, T. (2019). Excavating AI: The Politics of Training Sets for Machine Learning. ↑

- Angwin, J., Larson, J., Mattu, S., & Kirchner, L. (2016). Machine Bias: There’s software used across the country to predict future criminals. And it’s biased against blacks. ProPublica.Org. ↑

- O’Neil, C. (2016). Weapons of Math Destruction. New York: Crown. ↑

- Zarsky, T. (2011). Governmental Data Mining and its Alternatives. Penn State Law Review, 116(2), p. 311. ↑

- Zarsky, T. (2011). Governmental Data Mining and its Alternatives. Penn State Law Review, 116(2), p. 312. ↑

- Zarsky, T. (2011). Governmental Data Mining and its Alternatives. Penn State Law Review, 116(2), p. 312. ↑

- Rorty, R. (1991). Solidarity or objectivity?, en Objectivity, Relativism, and Truth. New York: Cambridge University Press. ↑

- Rorty, R. (1991). Solidarity or objectivity?, en Objectivity, Relativism, and Truth. New York: Cambridge University Press, p. 22. ↑